Object Storage

Unser S3-kompatibler Object Storage bietet Speicherplatz zum Hochladen und Verwalten von Daten in "Buckets". Alle Daten, die in einem Bucket gespeichert werden, werden in einem Ceph-Cluster gespeichert. Wenn die Sichtbarkeit eines Buckets auf öffentlich gesetzt wird, kann über die folgende URL jeder auf das Bucket zugreifen und Daten herunterladen:

<bucket-name>.<standort>.your-objectstorage.com/<datei-name>Object Storage wird hauptsächlich zum Speichern und Teilen von Daten genutzt, da es nicht möglich ist, Daten zu bearbeiten, nachdem diese in ein Bucket hochgeladen wurden (Objekte sind unveränderlich). Damit ist der Hauptzweck: Write once, read many (WORM). Mögliche Verwendungszwecke:

- (Automatische) Backups speichern

- Daten über eine öffentliche URL teilen

Buckets sind ein eigenständiges Feature, das unabhängig von unseren weiteren Cloud Ressourcen genutzt werden kann. Wesentliche Funktionen, wie das Erstellen eines Buckets oder das Anlegen von Keys, können über die Hetzner Console vorgenommen werden. Alle weiteren Feature können hingegen ausschließlich über unsere S3-kompatible API genutzt werden. Unsere API kann über folgende Optionen genutzt werden:

- Amazon S3-kompatible Tools empfohlen

- Amazon S3 REST API mit Hetzner S3 Endpunkt

In dem Artikel "Liste unterstützter Actions" können Sie prüfen, welche S3 Features unser Object Storage aktuell unterstützt.

Verfügbare Endpunkte

| Standort | Endpunkt |

|---|---|

| Falkenstein | fsn1.your-objectstorage.com |

| Nürnberg | nbg1.your-objectstorage.com |

| Helsinki | hel1.your-objectstorage.com |

Preise

Object Storage hat einen Grundpreis pro Account. Diesen berechnen wir Ihnen pro Stunde mit einer monatlichen Preisobergrenze, unabhängig davon, wie viele Buckets Sie haben und in wie vielen verschiedenen Projekten oder Standorten sie sich befinden.

Der Grundpreis beinhaltet ein Kontingent an Speicher und ausgehendem Traffic, das sich mit jeder Stunde, die Sie Object Storage nutzen, ansammelt. Am Ende des Monats wird das im Monat angesammelte Kontingent von Ihrer Gesamtnutzung aller Buckets abgezogen.

Speicher und Traffic, die über das im Grundpreis enthaltene Kontingent hinausgehen, werden nach einem "pay as you go" Abrechnungsmodell abgerechnet, das sich nach der Gesamtnutzung Ihres Kontos richtet.

Nicht genutztes Inklusivkontingent verfällt am Ende eines jeden Monats und kann nicht auf den nächsten Monat übertragen werden.

Genauere Informationen bezüglich der Preise finden Sie unter hetzner.com/storage/object-storage.

Folgendes ist kostenfrei:

- Eingehender (ingress) Traffic

- Interner Traffic innerhalb der Netzwerkzone

eu-central(siehe Übersicht der Netzwerkzonen) - S3 Operationen wie PUT, GET und DELETE

Grundpreis

Jede Stunde, in der Sie mindestens einen aktiven Bucket haben, wird Ihnen in Rechnung gestellt, auch wenn dieser leer ist. Am Monatsende werden Speicherplatz und Traffic aller Buckets aus allen Projekten zusammengefasst und gemeinsam abgerechnet.

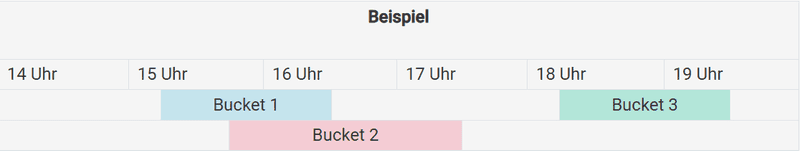

Im folgenden Beispiel wird Object Storage um 15 Uhr, 16 Uhr, 17 Uhr, 18 Uhr und 19 Uhr genutzt, d. h. in jeder dieser Stunden war mindestens ein Bucket aktiv. Daher werden Ihnen insgesamt fünf volle Stunden in Rechnung gestellt.

Inklusivkontingent

Da Monate unterschiedlich lang sind und somit unterschiedlich viele Stunden besitzen, ist das maximale monatlich enthaltene Kontingent abhängig vom Monat.

Zeitumstellungen sind hierbei nicht berücksichtigt

| Gesamt-Speicher pro Account | Gesamt-Traffic pro Account | |

|---|---|---|

| Monat mit 31 Tagen | max. 744 TB-Stunde | max. 1,1160 TB |

| Monat mit 30 Tagen | max. 720 TB-Stunde | max. 1,0800 TB |

| Monat mit 29 Tagen | max. 696 TB-Stunde | max. 1,0440 TB |

| Monat mit 28 Tagen | max. 672 TB-Stunde | max. 1,0080 TB |

In folgendem Beispiel wurden drei Buckets (blau, rosa, grün) genutzt. Diese Buckets waren während des gesamten Monats die einzigen Buckets, die erstellt wurden. Am Ende des Monats wird der Verbrauch folgendermaßen abgerechnet:

- Object Storage wurde insgesamt über einen Zeitraum von 3 Stunden genutzt. Das ergibt ein Inklusivkontingent von 3 TB-Stunden Speicher und 0,0045 TB Traffic.

- Innerhalb dieser drei Stunden wurden insgesamt die vollen 0,0045 TB Traffic und lediglich 2,3 TB-Stunden Speicher verbraucht. Somit blieben 0,7 TB-Stunden Speicher des Inklusivkontingents unverbraucht. Diese sind nun verfallen.

- Da der Verbrauch innerhalb des Inklusivkontingents blieb, werden keine zusätzlichen Kosten berechnet.

| Beispiel | ||||

|---|---|---|---|---|

| 16 Uhr | 17 Uhr | 18 Uhr | 19 Uhr | |

| Speicher: 0,3 TB-Stunde Traffic: 0,0010 TB |

Speicher: 1,5 TB-Stunde Traffic: 0,0010 TB |

Speicher: 0,3 TB-Stunde Traffic: 0,0025 TB |

||

| Speicher: 0,2 TB-Stunde Traffic: 0 TB |

||||

Kosten für die Nutzung über das Inklusivkontingent hinaus

Wir berechnen Ihnen den zusätzlichen Speicherplatz und Traffic in Schritten von 100 MB (= 0,0001 TB). Wenn Sie nicht die vollen 1 TB nutzen, wird Ihnen entsprechend weniger in Rechnung gestellt.

Der Preis für zusätzlichen Speicher errechnet sich wie folgt:

(Nettopreis * TB-Stunden) + 19 % USt.Minimale abrechenbare Objektgröße

Mindestgröße:

- 64 kB

Die Mindestgröße eines abrechenbaren Objekts ist die Größe, die Ihnen in Rechnung gestellt wird, auch wenn die tatsächlich gespeicherten Daten kleiner sind.

Objekte, die kleiner als diese Mindestgröße sind, werden so berechnet, als ob sie diese Größe hätten.

Ressourcen und Attribute

Folgende Ressourcen und Attribute hängen mit diesem Feature zusammen:

- Name

- Sichtbarkeit (

privatöffentlich) - Access Key

- Secret Key

Hinweis: Jedes "Access Key & Secret Key"-Paar kann automatisch für jeden Bucket innerhalb desselben Projekts verwendet werden. Für Tipps, um die Sicherheit zu erhöhen, siehe diesen FAQ-Eintrag "Wie begrenze ich die Zugriffsrechte eines einzelnen Keys?".

Limits

- Bis zu 8 kB an Metadaten pro Objekt

- Bis zu 5 GB pro Objekt in einer einzelnen PUT-Anfrage

- Bis zu 5 GB pro Objektteil bei einem Hochladen von Objekten in mehreren Teilen

- Bis zu 10.000 Teile bei einem Hochladen von Objekten in mehreren Teilen

- Bis zu 5 TB pro Objekt

- Bis zu 256 aktive parallele (TCP-) Sitzungen pro Quell-IP

- Bis zu 750 requests/s pro Quell-IP

- Bis zu 750 requests/s pro Bucket

- Bis zu 10 Gbit/s pro Bucket (lesend oder schreibend)

- Bis zu 100 TB pro Bucket

- Bis zu 50.000.000 Objekte pro Bucket

- Bis zu 200 S3-Zugangsdaten über alle Projekte

- Bis zu 100 Buckets über alle Projekte